Document original : anglais, traductions disponibles : Tchèque | Japonais | Espagnol

David A. Wheeler

Document du 7 mai 2003

Pour la traduction française : Marie-Claude Boitelle - SIL-CETRIL

Cette étude expose des données quantitatives relatives au open source software / free software. L'analyse de diverses mesures est la meilleure façon de quantifier ses atouts. Le but de cet article est de montrer que vous pouvez vous considérer utilisateur d'un Logiciel en Source Ouverte (OSS - Open Source Software) ou d'un Logiciel Libre (FS - Free Software) dès que vous vous portez acquéreur d' un logiciel.

Cet article analyse la les parts de marché , la fiabilité , la performance, l' adaptabilité, la sécurité, et le coût total de propriété. Vous trouverez aussi des articles sur les aspects non quantifiables, les craintes non fondées, un Compte-rendus d'utilisation, d' autres sites traitant du sujet, et quelques conclusions. Une annexe propose plus d'information générales sur les OSS/FS (définitions, motivations des développeurs, historique,types de licenses et “forking”). Vous pouvez consulter cet article en format HTML à l'adresse suivante : http://www.dwheeler.com/oss_fs_why.html . Les utilisateurs de Palm PDA peuvent le consulter en format Plucker (vous aurez besoin de Plucker pour le lire). Un résumé de cet article est disponible en format PDF et en format Open Office Impress (pour ce dernier, utiliser Open Office Impress). Des copies d'archives et une liste des modifications sont aussi disponibles.

Les Open Source Software / Free Software (OSS/FS) ont acquis une grande notoriété. Brièvement, les programmes OSS/FS sont des logiciels dont les licences donnent aux utilisateurs la possibilité de les exécuter librement quel qu'en soit leur usage, de les étudier, de les modifier, de redistribuer des copies du logiciel original ou de sa version modifiée (sans avoir à rétribuer le développeur d'origine).

Le but de cet article est de montrer, en se basant sur des mesures quantitatives, que vous devriez considérer l'utilisation d'OSS/FS lorsque vous recherchez un nouveau logiciel. Certains sites encouragent l'utilisation d'OSS/FS mais pour beaucoup d'utilisateurs, cela ne se justifie pas. l'utili A partir de données quantitatives (telles que les études de marché et les expériences), cet article tente de prouver qu'utiliser un OSS/FS est judicieux. Bien que je préfère de beaucoup les OSS/FS, je ne suis pas sectaire. J'utilise aussi bien les logiciels propriétaires que les OSS/FS. Les vendeurs de logiciels propriétaires travaillent dur pour promouvoir leurs produits. Cette étude fournit un antidote utile pour comparer les produits propriétaires et les OSS/FS, au moyen de chiffres significatifs.

Le but n'est pas de prouver que tous les OSS/FS sont meilleurs que les logiciels propriétaires. Beaucoup d'utilisateurs le croient d'un point de vue éthique, moral et social. Cependant, aucun chiffre ne pourrait prouver leur suprématie. Je vais donc simplement comparer des OSS/FS courants à des logiciels propriétaires courants de façon à prouver que dans certains cas, certains OSS/FS sont aussi performants, voire meilleurs, que des logiciels propriétaires. Bien sûr, il existe de mauvais logiciels OSS/FS sur le plan technique comme il y a de mauvais logiciels propriétaires, et même de très bons programmes peuvent ne pas répondre à vos besoins. Bien que beaucoup de gens comprennent la nécessité de comparer des produits propriétaires avant de les acheter, beaucoup d'entre eux ne considèrent pas les produits OSS/FS. Cet article tente d'expliquer aux acquéreurs potentiels l'utilité de tenir compte des OSS/FS.

Cet article n'étudie pas le passage aux OSS/FS mais il faut noter que les organismes peuvent passer aux OSS/FS en partie ou par étape , ce qui est une approche plus pragmatique.

Je m'attarderai sur le système d'exploitation (OS - Operating System) connu sous le nom de GNU/Linux (souvent nommé “Linux”) et sur le serveur Web Apache, les deux projets OSS/FS les plus répandus. Je comparerai tout d'abord les OSS/FS aux produits Microsoft (tels que Windows et IIS) puisque Windows détient une part significative du marché et que Microsoft propose la plupart des logiciels propriétaires. Je mentionnerai les systèmes Unix au passage puisque la situation au regard de cet OS est plus complexe : les systèmes Unix comprennent beaucoup de composants OSS/FS ou des logiciels issus de composants OSS/FS. A partir de ce constat, la comparaison des systèmes Unix propriétaires aux systèmes OSS/FS ne peut être précise. J'utilise le terme "de type Unix" pour qualifier des systèmes intentionnellement similaires à Unix. Unix et GNU/Linux sont des sytèmes "Unix-like". Le plus récent OS de Apple Macintosh (Mac OS OS X) présente le même problème : les anciennes versions du Mac OS étaient entièrement propriétaires, mais l'OS d'Apple a été reconçu pour être basé sur un système Unix et utilise beaucoup les OSS/FS. De ce fait, Apple encourage ouvertement la collaboration avec les développeurs d'OSS/FS . L'étude des chiffres s'étale sur plusieurs années, et non sur l'année précédente uniquement. Toutes les données significatives, même les plus anciennes, doivent être prises en compte dans une décision. D'ailleurs, ces dernières révèlent que le OSS/FS a une histoire positive sous divers aspects.

Vous obtiendrez plus de précisions sur les termes "logiciel ouvert" et "logiciel libre" en consultant l'appendice et ma liste de références sur les OSS/FS à l'adresse http://www.dwheeler.com/oss_fs_refs.html . Notez que celui qui utilise les terme “logiciel ouvert - Open Source Software” tendent à mettre l'accent sur leurs avantages techniques (meilleures fiabilité et sécurité). Par contre, ceux qui utilisent le terme “Logiciel Libre - Free Software” mettent en avant la notion de liberté de contrôle du logiciel et/ou son aspect éthique. Le contraire de OSS/FS est logiciel "fermé" ou "propriétaire". Les logiciels dont le code source peut être lu mais non modifié et qui peuvent être redistribués sans restrictions ( par exemple : "source visible", logiciel "open box", "source partagée" et "sous licence de communauté") ne sont pas considérés ici. Ils ne correspondent pas à la définition du OSS/FS. Beaucoup d'OSS/FS sont des programmes commerciaux. Il ne faut donc pas penser qu'ils sont "non-commerciaux" ou gratuits. Presque aucun OSS/FS n'est dans le "domaine public" (terme qui a un sens légal spécifique). Il faut donc éviter ce qualificatif. D'autres termes sont utilisés pour les OSS/FS : "libre software", "free-libre" et "open source software" (FLOS software ou FLOSS), open source/Free Software (OS/FS), free/open source software (FOSS), open-source software (open-source étant un adjectif), "free software" et même "public service software" (dans la mesure où ces projects sont destinés à un large public). Un OSS/FS n'est pas un "freeware" (logiciel gratuit). Un "freeware" est souvent un logiciel propriétaire diffusé gratuitement et ne donne pas le droit de l'étudier, de le modifier ou de le redistribuer. La license OSS/FS la plus connues est la General Public License (GPL). Tous les logiciels inscrit sous GPL sont des OSS/FS, mais tous les OSS/FS n'ont pas la GPL. Cependant, certains utilisent de façon abusive le terme de "logiciel GPL" lorqu'ils parlent de OSS/FS.

Voici un tableau des abréviations les plus utilisées dans cet article :

|

Abréviation |

Signification |

|

|

GNU |

GNU’s Not Unix (Un système d'exploitation OSS/FS) |

|

|

GPL |

General Public License (la license OSS/FS la plus courante) |

|

|

OS, OSes |

Operating System (Système d'exploitation), Systèmes d'Exploitation |

|

|

OSS/FS |

Open Source Software/Free Software - Logiciel Ouvert/Logiciel Libre |

|

On pense souvent qu'un produit est un succès s'il détient une grande part de marché. Ceci est évident et il y a des raisons pour pour cela : des produits qui occupent de large parts de marché attirent des utilisateurs qualifiés et sont appelés à se développer, ce qui réduit les risques futurs. Certains accusent le OSS/FS ou GNU/Linux de ne pas être au premier plan. Cette idée est obsolète au vu de la large utilisation qui en est faite. Il est évident que le OSS/FS détient une large part de marché dans différents domaines :

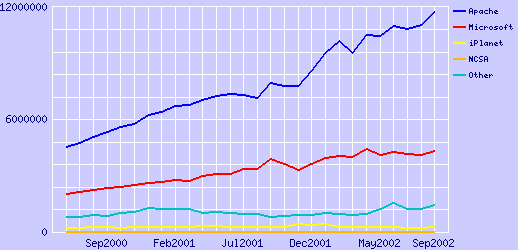

1. Le serveur Web le plus répandu a toujours été un OSS/FS depuis que l'on recense de telles informations. Par exemple, Apache est actuellement le serveur Web numéro 1. Il détient plus de deux fois la part de marché de son concurrent immédiat. Les statistiques de Netcraft relatives aux serveurs web ont toujours montré la domination d'Apache (un serveur Web OSS/FS) sur le marché public des serveurs web Internet depuis son accession à la première place en avril 1996. Avant cette date, le serveur web du NCSA (l'ancêtre d'Apache) dominait le monde du web d'août 1995 à mars 1996. C'est aussi un OSS/FS.

Depuis 2000, Netcraft a essayé de recenser séparément les sites web "actifs". Le problème est que beaucoup de sites ont été créés et ne sont en réalité que des sites "passifs" (leur nom de domaine a été réservé mais ils ne sont pas utilisés). Le choix de décompter seulement les sites actifs est plus révélateur que de décompter tous les sites web, dans la mesure où le choix du serveur web a été effectué par ceux qui développent réellement un site web. En ne tenant compte que des sites actifs, en septembre 2000, Apache couvrait 66.04% du marché des serveurs web, Microsoft en détenait 24.18%, iPlanet,1.57% et Zeus, 1.34%.

Répartition des parts de marché des serveurs web actifs de juin 2000 à septembre 2002

L'enquête de Netcraft datée de septembre 2002 comptabilisait les sites web identifiés par leur adresse IP au lieu d'un nom d'hôte. Cela a eu pour effet de ne pas tenir compte des ordinateurs destinés à servir divers sites et les sites à plusieurs noms. En comptant avec les adresses IP, Apache passa de 51% début 2001 à 54% alors que Microsoft restait inchangé à 35% des parts de marché.

Cette même enquête interrogea par nom d'hôte tous les sites web possible (au total 35 456 436 sites) , actifs ou non, et montra qu' Apache détenait 59.91% du marché, Microsoft, 29.18, iPlanet, 2.08% et Zeus, 1.36%.

La domination d'Apache a été démontrée de façon indépendante par E-soft . Leur étude du marché du serveur web publiée le premier octobre 2002 interrogeait 9 045 027 serveurs web en septembre 2002. Apache détenait 66.75% des parts de marché, Microsoft IIS, 21.83%. E-soft a fait un rapport spécifique sur les serveurs sécurisés (serveurs qui supportent SSL/TLS tels que les sites de e-commerce). Même dans ce domaine, Apache détient 51.26% du marché, Microsoft, 34.85%, Netscape/iPlanet, 5.68% et Stronghold 2.71%. Comme Stronghold est une distribution parallèle d'Apache, la part de marché réelle d'Apache est au moins de 53.97% .

Evidemment, ces chiffres évoluent mensuellement. Vous pouvez vous référer à Netcraft ou à E-soft pour consulter les toutes dernières évaluations.

2. GNU/Linux est en deuxième OS serveur dans le domaine de l'Internet publique (si l'on compte les machines physiques) selon une étude de Netcraft effectuée de mars à juin 2001. Certaines des études de Netcraft ont tenu compte des données relatives aux Systèmes d'Exploitation. Deux enquêtes (effectuées en juin 2001 et en Septembre 2001) montrent que GNU/Linux est le Système d'Exploitation numéro 2 pour les serveurs web si l'on compte les machines physiques (et a constamment gagné des parts de marché depuis février 1999). Comme Netcraft le précise, l'enquête sur les serveurs web exposée plus haut dénombre les serveurs web par leur nom d'hôte plutôt que par machine physique. Elle ne mesure donc pas la base matérielle installée. Des entreprises peuvent faire fonctionner plusieurs milliers de sites web sur un ordinateur et la plupart des site web du monde sont situés chez un hébergeur. De ce fait, Netcraft a développé une technique qui indique le nombre d'ordinateurs utilisés en tant que serveur web ainsi que l'OS et le logiciel serveur utilisé (en demandant à plusieurs adresses IP de répondre à Netcraft simultanément et en analysant les réponses). Netcraft a donc développé une technique qui dénombre les machines serveurs Web utilisant un OS et un logiciel serveur web (en analysant les réponses simultanées de beaucoup d'adresses IP). C'est une approche statistique, donc plusieurs visites du site sont faites sur un mois pour acquérir une certitude suffisante. Dans certains cas, le SE détecté est celui d'un périphérique “de façade” plutôt que le serveur web qui exécute réellement la tâche. Cependant, Netcraft pense que la marge d'erreur est de plus ou moins 10% et c'est en tout cas, l'information disponible la plus fiable.

Avant de présenter les données, il est important d'expliquer le système de datage de Netcraft. Cet organisme date ses informations au moment du recensement sur le serveur (et non au moment de la plublication) et utilise les résumés des sondages relatifs aux OS des mois précédents. Par exemple, l'enquête datée de Juin 2001 a été publiée en juillet et recence les résultats de l'enquête sur les OS de mars 2001 alors que l'enquête datée de septembre 2001 a été publiée en octobre 2001 et inclut les résultats du sondage sur les OS de juin 2001.

Voici un résumé des résultats de l'étude de Netcraft :

|

groupe d'OS |

Pourcentage (Mars) |

Pourcentage (Juin) |

Composition |

|

Windows |

49.2% |

49.6% |

Windows 2000, NT4, NT3, Windows 95, Windows 98 |

|

[GNU/]Linux |

28.5% |

29.6% |

[GNU/]Linux |

|

Solaris |

7.6% |

7.1% |

Solaris 2, Solaris 7, Solaris 8 |

|

BSD |

6.3% |

6.1% |

BSDI BSD/OS, FreeBSD, NetBSD, OpenBSD |

|

Autre Unix |

2.4% |

2.2% |

AIX, Compaq Tru64, HP-UX, IRIX, SCO Unix, SunOS 4 et autres |

|

Autre non-Unix |

2.5% |

2.4% |

MacOS, NetWare, propriétaire IBM OSs |

|

Inconnu |

3.6% |

3.0% |

non identifié par le détecteur d'OS de Netcraft |

Tout dépend de ce que vous voulez mesurer. Plusieurs des BSDs (FreeBSD, NetBSD, et OpenBSD) sont aussi des OSS/FS,ce qui fait qu'une part des 6.1% de BSD devraient être ajouté aux 29.6% de GNU/Linux pour déterminer le pourcentage des systèmes d'eploitation OSS/FS utilisés comme serveur web. Ce qui permet de dire qu'à peu près 1/3 des ordinateurs serveurs utilisent des systèmes d'exploitation OSS/FS. Il faut noter quelques différences régionales. Par exemple, GNU/Linux supplante Windows en Allemagne, Hongrie, République Tchèque et Pologne.

Des sites connus tels que Google (GNU/Linux) et Yahoo (FreeBSD) utilisent des OSS/FS.

Dans cette étude, vous trouverez également la situation du marché des serveurs web "Unix contre Windows". Tous les différents OSes Windows sont référencés sous un même numéro (même Windows 95/98 et Windows 2000/NT4/NT3 sont regroupés, alors qu'ils sont fondamentalement différents). De même, si l'on regroupe tous les systèmes "Unix-like", on trouve un total de 44.8% contre 49.2% pour Windows en mars 2001.

Ces chiffres seraient sûrement bien différents si l'on dénombrait les adresses web au lieu des ordinateurs physiques. Dans ce cas, une grande majorité des sites sont hébergés sur des systèmes "Unix-like". "Puisqu'Apache, installé sur divers systèmes Unix, gère plus de sites que Windows, il s'est largement imposé auprès des hébergeurs et des fournisseurs d'accès Internet qui tendent à gérer un maximum de sites afin de baisser leurs coûts" précise Netcraft.

3. GNU/Linux est l'OS serveur numéro 1 de l'Internet public (dénombré par nom de domaine) selon une enquête auprès des sites éducatifs et Européens effectuée en 1999.

La première étude relative à la pénétration du marché par GNU/Linux a été effectuée par Zoebelein en avril 1999. Elle mit en évidence qu'en 1999, l'OS le plus utilisé était GNU/Linux (28.5%) sur les serveurs http, ftp et sur les serveurs de news d'Internet . Il faut noter que cette étude était la première qui me permettait d'essayer de répondre à la question des parts de marché, en utilisant des bases de données serveurs existantes dans le domaine éducatif (.edu) et la base de données RIPE (qui couvre l'Europe, le CEntre-Est, une partie de l'Asie et de l'Afrique). Cependant elle ne reflète qu'une partie de la situation puisqu'elle omit les domaines ".com" et ".net". Le dénombrement s'est effectué par nom de domaine ce qui explique la différence avec l'étude relative aux OSes de Netcraft, datée de juin 2001. Cette analyse a aussi tenu compte des serveurs de news et des serveurs ftp et pas seulement les serveurs http.

Voici comment les différents OSes se répartissent dans l'étude :

|

Système d'exploitation |

Part de marché |

Composition |

|

GNU/Linux |

28.5% |

GNU/Linux |

|

Windows |

24.4% |

Tous les Windows(y compris 95, 98, NT) |

|

Sun |

17.7% |

Sun Solaris ou SunOS |

|

BSD |

15.0% |

Famille BSD (FreeBSD, NetBSD, OpenBSD, BSDI, ...) |

|

IRIX |

5.3% |

SGI IRIX |

Une part de la famille BSD étant aussi OSS/FS, la part totale des OSes OSS/FS est donc supérieure. En effet, si plus des 2/3 des BSDs sont des OSS/FS, alors le pourcentage total tournerait autour de 40%. Les défenseurs des systèmes "Unix-like" remarqueront que la majorité des Oses OSS/FS (plus ou moins 66%) étaient installés sur lesdits systèmes alors que 24% utilisaient une variante de Microsoft Windows.

4. GNU/Linux était le deuxième OS serveur le plus vendu en 1999, 2000, et 2001. Selon une étude d' IDC effecutée en juin 2000 sur les licences 1999, 24% des serveurs (Internet et Intranet) installés en 1999, utilisent GNU/Linux. Windows NT vient en premier avec 36% et tous les Unix totalisent 15%. De même, puisque certains Unix sont des systèmes OSS/FS (FreeBSD, OpenBSD, et NetBSD), le nombre de systèmes OSS/FS est en fait supérieur à celui de GNU/Linux. Mais tout cela dépend de ce que l'on souhaite dénombrer. Dans cette enquête, 39% de tous les serveurs installés étaient "Unix-like", ce qui donne 24%+15%. Les serveurs "Unix-like" étaient en fait les numéros un sur le marché dès lors que l'on compte GNU/Linux et Unix ensemble.

IDC réalisa une étude similaire le 17 janvier 2001, "Les systèmes d'exploitation serveurs en 2000". Les nouveaux OSes serveur vendus se répartissent ainsi : Windows, 41% avec une progression de 20%, GNU/Linux , 27% avec une progression de 24% et les autres "Unix", 13%.

Le rapport d'IDC, en 2002, trouva que Linux stagnait avec 25% des parts de marché. Tout ceci est particulièrement étrange puisque GNU/Linux détenait 0.5% du marché en 1995 selon une étude de Forbes d'IDC . De tels chiffres (et le coût utilisateur étudié plus loin) ont inspiré un des directeurs d'IT en novembre 2001 : "Linux pour le bureau n'est pas encore mûr mais pous le serveur, il est incontournable ."

Ces mesures ne tiennent pas compte de tous les systèmes installés cette année-là. Certains systèmes Windows sont piratés et des OSes OSS/FS tels que GNU/Linux et BSD sont souvent téléchargés et légalement installés sur plusieurs systèmes.

Enfin, une étude publiée en octobre 2002 par un analyste IT de la société Butler Group, conclut qu'en 2009 ou avant, Linux et Microsoft auront complètement pénétré le marché de l'OS serveur depuis le serveur de fichiers et d'édition jusqu'à l'ordinateur central.

5. GNU/Linux et les systèmes Windows (combinaison de Windows CE et XP) dominent principalement le secteur du développement des futurs projets embarqués , selon l'Evans Data Corporation (EDC). L'enquête d'Evans Data Corp relative aux développeurs pour systèmes embarqués, datée de juillet 2002 posait aux développeurs la question suivante : "Pour chaque OS, indiquez si vous utilisez l'OS pour votre projet en cours ou si vous l'utiliserez pour votre prochain projet". 444 développeurs furent interrogés. 30.2% des développeurs utilisent ou souhaitent utiliser Linux alors que 16.2% affirment qu'ils utiliseront Windows CE et 14.4% utiliseront Windows XP Embarqué. Si l'on combine les deux systèmes Windows, ce dernier dépasse de peu Linux Embarqué (30.6% contre 30.2%). Cependant, Linux Embarqué a presque doublé son taux de croissance et combiner deux systèmes Windows différents dans une seule valeur est trompeur. Le système embarqué VxWorks de Wind River, l'encombrant leader du marché des logiciels embarqués, “est légèrement à la traîne de Linux Embarqué concernant l'utilisation dans les projets en cours, et par sa modeste croissance de seulement 2,9% pour l'avenir. Il est relégué en troisième place avec seulement la moitié du taux d'utilisation des deux leaders pour les futurs projets qui sont au coude à coude (Windows Embarqué et Linux Embarqué)”.

6. Une étude d' Evans Data publiée en novembre 2001 établit que 48.1% des développeurs internationaux et 39.6% des développeurs Américains ont pour objectif de transférer la plupart de leurs applications sur GNU/Linux. En octobre 2002, 59% des développeurs prévoyaient de programmer sous Linux dans l'année à venir . ( November 2001 edition of the Evans Data International Developer Survey Series). C'est surprenant car, il y a à peine un an, moins d'un tiers des développeurs du monde entier écrivait des applications pour GNU/Linux. Cette étude montra aussi que 37.8% des développeurs internationaux et 33.7% des développeurs américains ont déjà programmé sous Linux et plus de la moitié d'entre eux l'utilisent en toute confiance pour des applications pointues.

Evans Data enquêta en Octobre 2002. Cette enquête montrait que “Linux continuait à accroître sa base d'utilisateurs. 59% des sondés s'attendent à écrire des applications Linux l'année suivante.” De plus le Japonais Linux white paper 2003 établit que 49.3% des solutions IT vendues au Japon supportent Linux.

7. Une étude japonaise mit en évidence la large utilisation de GNU/Linux et le grand nombre de supports pour GNU/Linux. Le taux d'utilisation de GNU/Linux passa de 35.5% en 2001 à 64.3% en 2002 dans les entreprises japonaises et GNU/Linux était la plateforme la plus répandue pour les petits projets. Le livre Linux White Paper 2003 (publié par Impress Corporation) étudie l'utilisation de GNU/Linux au Japon . Il est écrit en Japonais. En voici un bref résumé :

L'enquête est divisée en deux parties : La première, "Entreprise utilisatrice", relative à 729 entreprises qui utilisent un serveur. La seconde, "Entreprise vendeuse", qui interroge 276 vendeurs d'ordinateurs serveurs, d'intégrateurs de systèmes, de développeurs, des fournisseurs de service, et des revendeurs de matériel. Les résultats les plus intéressants se trouvent dans le taux d'utilisation de Linux dans les entreprises, le taux de serveurs Linux vendus, et le taux d'utilisation d'un serveur Linux dans les projets d'intégration de système.

L'utilisation de serveurs Linux dans les entreprises :

|

Système |

2002 |

2001 |

|

Linux server |

64.3% |

35.5% |

|

Windows 2000 Server |

59.9% |

37.0% |

|

Windows NT Server |

64.3% |

74.2% |

|

Commercial Unix server |

37.7% |

31.2% |

Utilisation moyenne en 2002 :

|

Système |

Ave. units |

# samples |

|

Linux server |

13.4 |

N=429 (5.3 in 2001) |

|

Windows 2000 Server |

24.6 |

N=380 |

|

Windows NT Server |

4.5 |

N=413 |

|

Commercial Unix server |

6.9 |

N=233 |

La catégorie des serveurs Linux est celle qui a le plus augmenté depuis l'an dernier. La moyenne des unités serveur par entreprise a été multipliée par 2.5 pour passer de 5.3 à13.4 unités.

Ci-dessous le taux de serveurs GNU/Linux vendus en 2002 :

|

System |

Year 2002 Support |

|

Windows NT/2000 Server |

66.7% |

|

Linux server |

49.3% |

|

Commercial Unix server |

38.0% |

Ceci est le taux relatifs aux détaillants qui développent ou vendent des produits supportant le serveur Linux. Linux est déjà bien placé par rapport à ses concurrents. Les raisons d'utiliser un serveur Linux ont aussi été étudiées mais elles sont différentes d'un pays à l'autre. Pour comparer, vous pouvez voir le European FLOSS report.

|

Evolution future |

44.1% |

|

Demande des clients |

41.2% |

|

OS le plus important sur le marché |

38.2% |

|

Libre de license |

37.5% |

|

OS le plus adapté au projet |

36.0% |

|

Source Ouverte |

34.6% |

|

Fiabilité |

27.2% |

Ci-dessous, les chiffres relatifs à l'adoption d'un serveur Linux dans les projets d'intégration de systeme

|

Taille du projet (Million Yen) |

Linux |

Win2000 |

Unix |

|

|

|

2002 |

2001 |

2002 |

2002 |

|

0-3 |

62.7% |

65.7% |

53.8% |

15.4% |

|

3-10 |

51.5% |

53.7% |

56.3% |

37.1% |

|

10-50 |

38.3% |

48.9% |

55.8% |

55.8% |

|

50-100 |

39.0% |

20.0% |

45.8% |

74.6% |

|

100+ |

24.4% |

9.1% |

51.1% |

80.0% |

1 million de Yen = 8 000$ US. Les serveurs GNU/Linux sont les plus utilisés (62.5%) dans les petits projets (moins de 3 millions de Yens ou 24 000$). Leur utilisation est passée de 20% à 39% dans des projets plus importants (plus de 400 000$). Dans les projets de plus de 800 000$, Linux détient 24.4% du marché (principalement en remplacement des systèmes Unix propriétaire) . Sachant que beaucoup de projets (spécialement les projets importants) utilisent simultanément de multiples plateformes, les chiffres ne font pas un total de 100.

8. L'étude Européenne des Logiciels Ouverts et Libres révèle l'utilité des OSS/FS . (Free/Libre and Open Source Software (FLOSS): Survey and Study) . Ce rapport complet, publié en juin 2002, étudie beaucoup de paramètres, et en particulier l'utilisation des OSS/FS. Elle met en évidence la variabilité du taux d'utilisation des OSS/FS. En effet, 43.7% des établissement Allemands utilisent des OSS/FS, contre 31.5% pour les Anglais et 17.7% pour les Suédois. Il précise aussi que les OSS sont plus utilisés dans les grands établissements que dans les petits. Enfin, le taux d'utilisation des OSS dans le secteur public est supérieur à la moyenne.

9. Microsoft finance sa propre enquête pour "démontrer" que GNU/Linux n'est pas si largement utilisé, mais il a été prouvé que cette enquête n'était pas rigoureuse. Microsoft finança le Gartner Dataquest report stipulant que seulement 8.6% des serveurs vendus aux USA durant le troisième trimestre 200 étaient "basés-Linux". Cependant, on peut supposer que Microsoft (qui a payé cette enquête) a volontairement revu ces chiffres à la baisse car ils sont largement différents de ceux d'IDC. Kusnetzky de chez IDC déclara que l'explication la plus simple était que Gartner utilisait la définition de "vendu" de façon très limitée. Il pensait que le chiffre était raisonnable si l'on s'en tient aux nouveaux serveurs munis de Linux."Mais nos recherches ont montré que ce n'est pas ainsi que la plupart des utilisateurs se portent acquéreurs de Linux. Nous avons établi que 10 à 15% des acquisitions de Linux proviennent de machines pré-installées. Pour chaque Linux acheté, il peut y avoir 15 copies gratuites. " . Il est difficile d'acheter un ordinateur x86 sans un OS Microsoft (les contrats Microsoft-fabricants le prouvent) et cela ne veut pas dire que l'OS est utilisé. Gartner répliqua qu'il utilisait des questionnaires pour évaluer ce problème mais le résultat final de son enquête , comparé aux faits connus, laissent penser que Gartner n'a pas pris en compte ce paramètre. Par exemple, Gartner affirma que le nombre des ventes sans le domaine des super-ordinateurs était quasiment nul. En fait, Linux est largement utilisé dans le domaine scientifique ainsi que dans des domaines très pointus. Beaucoup de ces systèmes ont été assemblés en interne , ce qui montre que sa question fait que l'on ne tient pas compte des installations opérationnelles. L'article du Register “Personne n'utilise Linux” (couplé à “90% Windows..” ) en parlent plus largement. En bref, l'enquête auto-financée rapporte des chiffres très bas qui n'en restent pas moins suspects.

10. Les entreprises prévoient d'augmenter l'usage de GNU/Linux. Une étude de Zona Research révèle que plus de la moitié des grandes entreprises attendent une augmentation de plus de 25% des utilisateurs de GNU/Linux et près de 20% s'attendent à une augmentation de plus de 50%. Un tiers des responsables de petites entreprises s'attendent à une augmentation de plus de 50%. Les facteurs primodiaux de cette tendance sont la fiabilité, le coût moindre, la vitesse d'exécution des applications et l'adaptabilité. Voici quelques chiffres :

|

Usage attendu de GNU/Linux |

Petites Entreprises |

Moyennes Entreprises |

Grandes Entreprises |

Total |

|

50% d'augmentation |

21.0% |

16% |

19.0% |

19% |

|

10-25% d'augmentation |

30.5% |

42% |

56.5% |

44% |

|

Pas d'augmentation |

45.5% |

42% |

24.5% |

36% |

|

Baisse |

3.0% |

0% |

0% |

1% |

11. Vous trouverez plus d'informations sur le sujet en consultant “La nouvelle religion : Linux et le source ouvert” (ZDNet) l' InfoWorld du 5 Février 2001 ( article : “Linux lights up enterprise: But concerns loom about OS vendor profitability.”)

12. Les 1000 premiers fournisseurs de services Internet s'attendent à une augmentation de l'utilisation de Linux de 154%, selon l'étude d'Idaya, effectuée de juin à mars 2001. Une étude effectuée par Idaya auprès des 1000 premiers fournisseurs de services Internet montre que ces derniers s'attendent à une augmentation de GNU/Linux de plus de 154% en 2001. De plus, les 2/3 (64%) des fournisseurs de services estiment que les logiciels ouverts ont atteint un niveau comparable aux logiciels propriétaires. Il faut cependant tenir compte du fait qu'Idaya produit des OSS/FS.

13. Une étude européenne menée en 2002 montre que 49% les Directeurs de Systèmes d'Information (CIO-Chief Information Officer) des secteurs de la finance, de la vente au détail et du secteur public s'attendent à utiliser des OSS/FS. OpenForum Europe a publié en 2002 une étude intitulée Analyse de l'avenir des OSS/FS sur le marché. Les CIOs des secteurs financiers, de la distribution et du public ont été interrogés pendant plus de trois mois. Il en résulte que 37% des CIOs utilisent déjà des OSS/FS et 49% pensent les utiliser. Plus d'entreprises utilisent des OSS/FS mais leur CIOs n'en sont pas conscients. Les points forts des OSS/FS mentionnés sont la baisse des coûts (54% des sondés), le plus faible coût des licences (24%), un meilleur contrôle sur le développement (22%) et une sécurité accrue (22%).

14. IBM a mis en évidence une augmentation de 30% du nombre d'applications destinées aux entreprises utilisant GNU/Linux durant le premier semestre 2001. Il fut un temps où l'on disait que "trop peu d'applications destinées aux entreprises s'appuient sur Linux". Pourtant, IBM prouva que plus de 2300 applications GNU/Linux (une augmentation de 30% sur 6 mois) sont disponibles auprès d'IBM et des vendeurs de logiciels indépendants. Un Rapport spécial de Network Computing sur Linux en entreprise a étudié les points forts et les faiblesses de GNU/Linux et mit en évidence un bon nombre d'avantages à utiliser GNU/Linux dans des applications en entreprise.

15. Morgan Stanley a mis en évidence une augmentation significative de l'utilisation de GNU/Linux dans son enquête menée auprès de 225 Directeurs des Systèmes d'Information (CIO) en aout 2002. (Morgan Stanley surveyed 225 CIOs on August 2002.) Parmi les sondés, 29% affirment qu'ils possèdent des serveurs Linux, 8% en feront l'acquisition et 17% assurent s'intéresser aux serveurs GNU/Linux bien qu'ils ne l'utilisent pas officiellement. Les autres (46%) précisent qu'ils n'utilisent pas et ne s'intéressent pas à GNU/Linux. Pour ceux qui viennent d'acquérir des serveurs GNU/Linux, 31% voulaient augmenter les capacités du système, 31% remplacer des systèmes Windows, 24% remplacer d'autres OSes. Il est plus simple de passer de Unix à GNU/Linux que de Windows à GNU/Linux. Aussi, il est essentiel de noter que Windows a été plus souvent remplacé que Unix. CNet analyse cette étude et commente le source ouvert vs Windows.

16. Les revenus issus de la vente des systèmes serveurs basés GNU/Linux ont augmenté de 90% entre le 4ième trimestre 2001 et le premier trimestre 2002. Cette donnée a été révélée par Gartner Dataquest et reprise dans C|Net.

Les ventes de serveurs GNU/Linux ont augmenté de 63% entre 2001 et 2002. Selon Gartner, les ventes sont passées de 1.3 milliard de $ à 2 milliard de $.

17. Une étude menée en 2001 a montré que 46.6% des professionnels du traitement de l'information étaient assurés que leur organisme d'affiliation supporterait GNU/Linux ; Un chiffre bien supérieur aux autres OS excepté Windows. Une étude de TechRepublic Research intitulée " Références, Tendances et Prévisions : Le Rapport Linux" révèle que les professionnels du traitement de l'information croient fortement en Linux lorsqu'on leur demande de citer les différents OSes que pourraient supporter leur entreprise. Etant donné la domination du marché des ordinateurs par Windows, il n'était pas surprenant que la plupart des sondés étaient confiants dans la façon dont leurs systèmes supporteraient plusieurs versions de Windows (90.6% pour Windows NT, 81.6% pour Windows 2000). Cependant, GNU/Linux, venait en troisième position avec 46.4%. En effet, près de la moitié des sondés affirmèrent qu'ils étaient déjà confiants dans la façon dont leur système supporteraient GNU/Linux. Cela est particulièrement remarquable parceque GNU/Linux surpasse d'autres produits très connus et anciens tels que Unix (42.1%), Novell Netware (42.1%), Sun Solaris (39.5%) et Apple (13.6%). TechRepublic émet quelques hypothèses pour expliquer ce résultat :

o GNU/Linux est considéré comme une technologie qui se développe. Beaucoup de professionnels du traitement de l'information l'étudient et apprennent à l'utiliser, considérant qu'il sera incontournable dans un futur proche.

o Beaucoup de professionnels utilisent déjà GNU/Linux dans le privé, la meilleure façon de l'intégrer au monde professionnel.

o Puisque que GNU/Linux est similaire à Unix, les professionnels maîtrisant Unix peuvent facilement aborder GNU/Linux.

TechRepublic suggère que les cadres informaticiens évaluent les connaissances de leurs équipes car leurs systèmes peuvent déjà supporter Linux à moins qu'ils ne l'utilisent déjà.

18. Sendmail, un programme OSS/FS est le premier serveur e-mail . Une étude réalisée entre le 27/09/2001 et le 03/10/2001 par D.J Bernstein auprès d'1 million d'adresses IP choisies au hasard a permis la connection à 958 serveurs SMTP (aussi appelés MTAs). Il en résulte que Unix Sendmail détient la plus grande part du marché (42% des serveurs e-mail), suivi de Windows Microsoft Exchange (18%), Unix qmail (17%), Windows Ipswitch IMail (6%), Unix smap (2%), Unix Postfix (VMailer, 2%) et Unix Exim (1%). Notez que Bernstein développe un des concurrents de Sendmail (qmail). Il n'a pas d'intérêt à reconnaître que Sendmail a la plus grande part de marché. Qmail n'est pas un OSS/FS car on ne peut pas redistribuer librement des programmes dérivés de Qmail . On a accès au code source de Qmail ce qui fait croire à certaines personnes que Qmail est OSS/FS. En revanche, Sendmail, Postfix et Exim sont tous OSS/FS. Non seulement Sendmail est OSS/FS mais il est installé deux fois plus que son concurrent direct.

19. Une étude menée au second trimestre 2000 mit en évidence que 95% des serveurs de nom de domaine (DNS) utilisent Bind, un produit OSS/FS. Internet est composé d'éléments pour la plupart invisibles tels que les serveurs DNS qui affectent une adresse numérique à un nom de machine. Les machines accessibles au public effectuent généralement les “résolutions inverses" en convertissant les adresses en nom. Pour des raisons historiques, cette conversion est effectuée en utilisant le domaine caché "in-addr.arpa" . En interrogeant le domaine "in-addr" on peut étudier la façon dont tout Internet est organisé. Bill Manning a étudié ce domaine "in-addr" a établi que 95% des serveurs de nom (2ième trimestre 2000) offrant ce service utilisent une version de "bind", y compris tous les DNS root servers qui sont essentiels pour le fonctionnement d'Ineternet. Bind est un programme OSS/FS.

20. PHP est le numéro 1 des langages de script côté serveur sur le web. PHP, (ou Hypertext Preprocessor) est u langage de script côté serveur de source ouverte. Il a été conçu pour créer des pages Web dynamiques . Un article du 3 juin 2002 précise que PHP a récemment surpassé l'ASP de Microsoft et tend à devenir LE langage de script le plus utilisé sur le web (plus de 24% des sites). Sur 37.6 million de sites recensés, PHP est utilisé sur plus de 9 millions de sites. De plus, depuis 2 ans, l'utilisation de PHP augmente de 6.5% par mois.

21. OpenSSH est numéro 1 pour l'implémentation du protocole de sécurité SSH sur l'Internet. Le protocole Secure Shell (SSH) est largement employé pour sécuriser les connections et pour les contrôler à distance (en utilisant soit une interface en mode texte, soit une interface graphique sous X-Window). En avril 2002, un sondage effectué auprès de 2.4 millions d'adresses IP montra que OpenSSH, une implémentation OSS/FS de SSH, occupait la première place avec 66.8% du marché. En effet, le “SSH” propriétaire en détenait 28.1%, Cisco 0.4% et les autres totalisaient 4.7%. Vous pouvez consulter le site informations générales sur l'étude ou les statistiques SSH pour Avril 2002. Il est interessant de noter que OpenSSH détenait moins de 5% du marché au troisième trimestre 2000 mais que son utilisation n'a cessée de croître : au quatrième trimestre 2001, plus de la moitié des utilisateurs de protocole SSH utilisaient OpenSSH et ses parts de marché ne cessent de croitre.

22. GNU/Linux est peu représenté dans le monde des ordinateurs de bureau et des portables. Mais beaucoup de raisons laissent croire que son implantation sera plus large dans le futur. Beaucoup d'utilisateurs ont acquis leur expérience sur des ordinateurs de bureau ou sur des portables en faisant fonctionner des "applications clientes de base" tels que les navigateurs, les lecteurs de courrier électronique, les traitements de texte, les tableurs et les logiciels de présentation (les trois derniers étant regroupés sous le terme de "suite bureautique"). Ces outils sont souvent utilisés avec des applications clientes additionnelles et doivent comporter une interface graphique, sur fond d'environnement graphique. De tels ordinateurs sont appelés "clients" (même s'ils ne suivent pas le modèle client-serveur). Les systèmes OSS/FS tels que GNU/Linux proposent une large gamme d'applications pour développeurs et serveurs et commencent seulement à s'imposer sur le marché des OS clients. Quelques chiffres illustrent ce propos.

Selon une étude d'IDC effectuée en juin 2000 basée sur 1999 licenses GNU/Linux était presque aussi bien implanté que le MacOS d'Apple (5.0% pour MacOS et 4.1% pour GNU/Linux). Un sondage plus récent révèlerait que le taux de GNU/Linux est de 1.7% sur le marché de l'OS Client. Evidemment, alors que ces chiffres confirment le nombre élevé d'utilisateurs (car il y a beaucoup de systèmes clients) le taux reste encore très faible comparé au monopole évident de Microsoft sur le marché des OS clients. IDC rapporte que les systèmes Windows totalisent 92% des OS clients vendus.

Mais ceci n'est pas surprenant parce qu'avant 2002, les systèmes OSS/FS tels que GNU/Linux n'étaient pas adaptés aux systèmes clients. Les utilisateurs ne pouvaient imaginer acheter un système sans applications clientes répondant à leurs besoins fondamentaux. Un système client doit être compatible avec le produit le plus répandu du marché ( La suite office doit pouvoir lire et écrire des documents sous format Microsoft Office) et les produits disponibles avant 2002 ne pouvaient le faire. Enfin, pour qu'un système GNU/Linux puisse être concurrentiel, les applications clientes de base et l'environnement doivent être aussi OSS/FS et cela n'est pas souvent bien compris. Il y a eu des applications clientes de base propriétaires pour GNU/Linux pendant plusieurs années mais elles n'ont pas réellement aidé GNU/Linux. En effet, un système GNU/Linux combinés avec des applications propriétaires remet en cause la notion de liberté et de coût réduit des systèmes purement OSS/FS. De plus , de tels systèmes entrent en concurrence avec d'autres systèmes propriétaires bien implantés qui disposent de beaucoup plus d'applications. Cela ne veut pas dire que GNU/Linux ne peut supporter de programmes propriétaires. Certains achèteront des applications clientes de base propriétaires et beaucoup sont décidés à acheter d'autres types d'applications propriétaires pour les installer sur un système GNU/Linux. Cependant, peu d'utilisateurs trouveront qu'un système GNU/Linux doté d'applications propriétaires sera meilleur que ses concurrents. Après tout, le résultat est toujours "propriétaire" et comme il y a moins d'applications GNU/Linux pour les ordinateurs de bureau, beaucoup d'avantages sont perdus, en terme de coût et de possibilités.

Heureusement, la situation change de façon radicale grâce à trois facteurs : Des OSS/FS clients de base sont disponibles, Microsoft augmente ses coûts et les gouvernements veulent des systèmes ouverts :

1. Des OSS/FS clients de base sont disponibles. En 1997 je prévoyais que GNU/Linux serait prêt pour l'ordinateur de bureau en 2002-2003, soit 5 ans plus tard. Et je ne me suis pas trompé. En effet, les applications OSS/FS et les environnements ont mûri et sont finalement compétitif sur le marché du système client. En 2002, Mozilla présentait enfin la version 1.0 de sa suite (constituée d'un navigateur, d'un lecteur de courrier et d'autres outils) ainsi qu'une première version raisonnablement utilisable d'Open Office (une suite de bureau). Les environnements de bureau ont aussi mûris. En effet, en 2002, les projets GNOME et KDE se révélèrent compétitifs. De plus, le produit WINE (qui permet aux systèmes OSS/FS de faire fonctionner des programmes Windows) était capable de supporter Microsoft Office 97. Cependant, bien qu'étant immature WINE est suffisant pour exécuter des applications Windows développées en interne par quelques entreprises.

Il existe d'autres applications clientes telles que Evolution (un excellent lecteur de courrier), Abiword (un traitement de texte simplifié), Gnumeric (un tableur) et KOffice (une suite de bureau).

Cependant, je m'interesserai essentiellement à Mozilla et Open Office pour deux raisons . Tout d'abord, ils fonctionnent aussi sous Microsoft Windows ce qui permet aux utilisateurs de migrer depuis leurs concurrents par étape. De plus, ils sont complets, y compris au niveau de leur compatibilité avec des produits Microsoft. Cela évite aux utilisateurs de passer d'un programme à l'autre pour atteindre une fonctionnalité. En bref, il semble que maintenant, plusieurs produits OSS/FS ont commencé à rivaliser avec leurs homologues propriétaires au niveau des fonctionnalités et de l'aisance d'utilisation.

2. Microsoft augmente ses prix. Microsoft change sa politique. Il en résulte une augmentation de coût pour ses clients. Il a changé le mode de fonctionnement des licences si bien qu'une copie de Windows ne peut être utilisée à la maison et au bureau, ce qui accroît les coûts pour ses clients. Microsoft a amené ses clients à accepter une approche basée sur la souscription (License 6), ce qui augmente largement les coûts. L' Etude de la licence des logiciels Microsoft effectuée par TIC/Sunbelt en mars 2002 met en évidence l'impact de ce nouveau schéma des licences sur les clients. 80% des sondés sont mécontents du nouveau coût de l'assurance sur les logiciels (25% pour les serveurs et 29% pour les clients), réputé le plus élevé du monde industriel. Parmi ceux qui ont analysé les coûts, 90% affirment qu'ils augmenteront s'ils migrent vers la version 6.0 et 76% affirment qu'ils augmenteraient de 20% à 300% s'ils migraient de la version 4.0 et 5.0 à la version 6.0 en suivant la politique des licences. De ce fait, 38% des sondés étudient d'autres alternatives aux produits Microsoft. La politique du Licensing 6.0 peut amener certaines firmes à tenter de céder une part de leur activité. Le programme impose le paiement accéléré de la maintenance des logiciels quand les ordinateurs couverts par la licence sont vendus. Mais Microsoft n'est pas tenu de continuer la maintenance même si les contrats ont été totalement acquités.

La revue de StarOffice par Gartner (La version Sun de Star Office) a mis en évidence que les licences de Microsoft feraient fuir ses clients. Gartner affirme : "Cette nouvelle politique a engendré beaucoup de mécontentement auprès des clients Microsoft qui s'informent sur les alternatives à la suite bureautique de Microsoft. Les entreprises se rendent compte que la majorité des utilisateurs n'ont pas besoin de toutes les fonctionnalités avancées de chaque version d'Office... Si Microsoft ne fait pas de concessions significatives sur sa politique de licence, StarOffice de Sun gagnera au moins 10% de part de marché aux dépens de Microsoft Office, fin 2004 (probabilité de 0.6)." . Il précise aussi : "A cause de cette nouvelle politique de licence, plus de 50% des entreprises auront une stratégie officielle qui mélange les versions de produits bureautiques avant fin 2003 – c'est à dire entre plusieurs versions d'Office de Microsoft ou d'autres venseurs (avec une probabilité de 0,7)”.

3. Les Gouvernements veulent des systèmes ouverts. Un article du New York Time a noté que "plus de 24 pays en Asie, Europe et Amérique Latine, y compris la Chine et l'Allemagne encouragent leurs services gouvernementaux à utiliser des logiciels ouverts, développés par des communautés de programmeurs qui distribuent le code gratuitement et qui en permettent la correction et la modification dans le but d'améliorer le produit."

Les avantages des OSS/FS sont évidents pour les gouvernements et en particulier pour les non-Américains. Aucun d'entre eux ne souhaite voir son infrastructure informatique contrôlée par une seule entreprise, qui plus est, étrangère. Jiang Guangzhi, directeur du centre de développement du logiciel à Shangai, insiste sur le fait que le gouvernement Chinois ne souhaitait pas voir une seule entreprise "manipuler et dominer le marché Chinois". IBM a signé un accord sur Linux avec l'Allemagne . Otto Schilly, ministre de l'intérieur Allemand, dit que cette tendance devrait faire baisser les coûts, améliorer la sécurité des réseaux nationaux et assurer une certaine indépendance vis à vis du fournisseur. Ralph Nader’s Consumer Project on Technology démontre au gouvernement US l'intérêt d'encourager les OSS/FS. Beaucoup de pays favorisent les OSS/FS tels que le Perou, le Royaume Uni et Taiwan. CNet a publié une étude dans ce sens en 2001.

Le gouvernement d'Afrique du Sud encourage officiellement l'abandon des logiciels propriétaires réputés coûteux, pour les OSS/FS. Le 15 janvier 2003, Mojalefa Moseki, responsable de la communication à la State Information Technology Agency (SITA), affirma que l'Afrique du Sud prévoit d'économiser 3 milliards de Rands (environ 338 millions de dollars US), d'accroître les dépenses logicielles locales et d'accroître les compétences en programmation à l'intérieur du pays. L'Afrique du Sud affirme que l'amorçage d'une telle politique lui a permis d'économiser 10 millions de Rands (soit $1.1 millions USD). Tectronic publie plus d'informations.. L'etat d'Oregon s'intéresse aussi aux OSS/FS.

L'exposé de Tony Stanco "On Open Source Procurement Policies" décrit brièvement les raisons pour lesquelles les gouvernements devraient s'intéresser aux OSS/FS.

En fait, les gouvernements qui ont commencé à légiférer en faveur des OSS/FS sont si nombreux que Microsoft a financé une organisation appelée Initiative pour le Choix Logiciel . Cette a fait de belles déclarations mais il apparaît que le but réel est d'interdire les gouvernements de prendre en compte les licences quand ils fournissent des logiciels et d'encourager des standards qui ferment la porte aux OSS/FS. A l'opposé, Sincere Choice.org, fondé par Bruce Perens prone un marché sain et compétitif où les logiciels ouverts et propriétaires auraient leur place. Bruce Perens a publié un article dans lequel il démontre que le "Software Choice" n'est pas ce qu'il semble être.

L'implantation croissante de GNU/Linux auprès de clients est prouvée. Des organismes, tels que TrustCommerce et la ville de Largo en Floride, affirment qu'elles ont réussi le passage à Linux sur les PC.

On a déjà des preuves qui montrent que d'autres s'y préparent. Richard Thwaite, le directeur informatique de Ford Europe, a déclaré en 2001 que leur but est d'avoir des ordinateurs de bureau avec un système à code source ouvert et de faire de même pour l'industriel à terme. (il controle 33 000 ordinateurs de bureau et ce n'est pas négligeable). On peut argumenter que c'est peut-être un moyen de négocier avec Microsoft, mais de telles pressions ne marchent que si elles sont crédibles.

Il existe d'autres sources d'informations sur les OSS/FS et sur Linux côté client. Desktoplinux.com est un site web consacré à l'utilisation de GNU/Linux sur les ordinateurs de bureau. En effet, ils affirment que "Linux est à présent prêt à être largement utilisé comme OS sur les ordinateurs de bureau, et nous avons crée ce site pour promouvoir son implantation , puisqu'il offre une plus grande liberté et un plus large choix aux utilisateurs."

Bien sûr, il apparaît que beaucoup d'utilisateurs s'intéressent à une telle transition. Une étude de ZDNet publiée le 22 aout 2002 posait la question suivante : "Est-ce que votre entreprise migrerait de Windows à Linux sur ses PCs si les applications fonctionnaient sous Linux ?". Il y eut plus de 15 000 réponses. 58% migreraient immédiatement, 25% opteraient pour Linux dans un délai d'un an. Bien qu'il ne faille pas prendre ces résultats pour argent comptant, c'est le style de réponse qu l'on trouve auprès d'utilisateurs assez mécontents de la situation. Ils précisent aussi que ZDNet Australia révéla que 55% des chefs de services informatique pensaient abandonner les produits microsoft. Beaucoup ne s'attendent pas à cette migration mais si elle s'effectue, ce sera rapidement.

On raconte que les OSS/FS sont plus fiables, mais beaucoup de chiffres prouvent que les programmes OSS/FS matures le sont encore plus.

1. Une étude menée en 1995 montre qu'à fonctionnalités équivalentes, les applications OSS/FS sont plus fiables que les applications commerciales. Le “Fuzz Revisited” publié en 1995 mesure la fiabilité en déterminant les programmes qui se bloquent après avoir reçu des caractères de façon aléatoire. Même si certains chercheurs estiment que cette approche n'est pas infaillible, elle permet de mettre en évidence beaucoup de disfonctionnements logiciels.

Ces tests ont mis en évidence la plus grande fiabilité des OSS/FS, comme indiqué dans la section 2.1.3

Il est intéressant de comparer les résultats des tests des systèmes commerciaux et ceux des logiciels libres GNU et Linux. Les sept systèmes commerciaux testés totalisaient un taux d'erreurs de 23% alors que le taux de Linux était de 9% et les utilitaires GNU de seulement 6%. On peut alors se demander pourquoi un groupe de programmeurs avertis, sans support de test ou sans standard de programmation peut produire un code plus fiable (selon nos mesures) qu'un code de type commercial. Même si l'on ne tient compte que des utilitaires disponibles pour Linux ou GNU, les taux d'erreurs sont meilleurs.

Il est évident que les applications Windows sont aussi fiables que les logiciels Unix propriétaires (mais moins que les OSS/FS). Un article récent, intitulé Une étude empirique de la robustesse des applications Windows NT au travers de tests utilisant des données aléatoires, mit en évidence que parmi les applications graphiques de Windows NT qu'ils avaient testés, 21% se plantaient et 24% se bloquaient. De plus, toutes les applications se plantaient quand elles recevaient des messages Windows aléatoires. Il n'y a donc aucune preuve permettant d'affirmer que les logiciels Windows propriétaires sont plus fiables que les OSS/FS. Windows a progressé depuis mais les OSS/FS aussi.

Bien que cette expérience se soit déroulée en 1995, aucun élément n'a été apporté depuis, prouvant la supériorité des logiciels propriétaires. L'intérêt porté aux OSS/FS depuis 1995 a permis de renforcer leur fiabilité.

Les auteurs de cet article trouvaient génant que les vendeurs de logiciels propriétaires ne corrigent pas les problèmes qui avaient été identifiés dans des versions précédentes de l'article. A l'inverse, Scott Maxwell mena une action pour supprimer tous les défauts trouvés dans le logiciel OSS/FS lors de cette étude de 1995. Finalement, il les corrigea tous. Cette réponse de la communauté OSS/FS montre pourquoi les programmes OSS/FS sont si orientés vers la fiabilité. Les problèmes trouvés sont souvent corrigés. Ce qui est plus surprenant encore est que la personne qui a pris en charge la correction n'est pas un des développeurs initiaux.

Soyons clairs, les OSS/FS ne sont pas infaillibles. En effet, les logiciels de version beta sont bogués. L'expérience de 1995 prenait en compte des logiciels OSS/FS et propriétaires réputés matures. Et le résultat est le suivant : les OSS/FS sont plus fiables suivant ce test.

2. GNU/Linux est plus fiable que Windows NT, suivant un test effectué sur 10 mois par ZDnet. ZDnet a effectué un test de fiabilité sur 10 mois et a comparé Caldera System OpenLinux, Red Hat Linux et Microsoft Windows NT Server 4.0 avec Service Pack 3. Ces trois OS utilisaient la même CPU et les requêtes (Internet, fichier, édition) étaient envoyées en parallèle à chaque serveur. Résultat : NT s'arrêtait en moyenne une fois toutes les six semaines, et il fallait 30 minutes pour le relmettre en route. Ce n'est pas mauvais mais jamais le serveur GNU/Linux n'est tombé en panne. Ce rapport de ZDnet a aussi mis en évidence les failles de GNU/Linux (par exemple les applications de bureautique et le parallélisme massif ). Heureusement, Windows s'est amélioré depuis cette étude. Mais les OSS/FS ont certainement fait de même.

3. GNU/Linux est plus fiable que Windows NT, selon une étude de Bloor Research, étalée sur un an. Bloor Research a aussi fait fonctionner les deux OS sur des machines relativement anciennes, munies de Pentium. Durant l'année de test, GNU/Linux s'est bloqué une fois en raison d'un problème matériel (Disque Dur). Le diagnostic a pris 4 heures ce qui correspond à une disponibilité de 99.95%. Windows NT s'est planté 68 fois, à cause de problèmes matériels (disque dur), de problèmes de mémoire (26 fois), de gestion de fichier (8 fois) , de problèmes variés (33 fois). Le diagnostic a pris 65 heures, ce qui donne un taux de disponibilité de 99.26%. Bizarrement, le seul problème de GNU/Linux est d'origine matériel ainsi que la plupart des problèmes de Windows. On pourrait en conclure que le matériel Windows était moins performant ou on pourrait en conclure que GNU/Linux a mieux évité et géré les problèmes matériels. La panne du système de gestion de fichiers est due à Windows et il apparaît que les divers autres problèmes sont dus aussi à Windows. GNet résume la suprématie de GNU/Linux par cette phrase : "Le gagnant est vraiment Linux".

4. Une étude réalisée par Reasoning montre que l'implémentation du protocole TCP/IP sur le noyau Linux est plus performante que son implémentation sur plusieurs OS propriétaires, et que Linux est aussi performant que les meilleurs OS embarqués. Comme stipulé dans leur article de presse et par C|Net, l'étude de Reasoning compare six implémentations de TCP/IP, le protocole fondamental sur lequel repose Internet. En plus du noyau Linux, trois des implémentations faisaient partie d'OS commerciaux classiques, et deux étaient embarqués dans des équipements de télécommunication commerciaux. Comme le noyau Linux est au départ utilisé pour un OS classique, on pouvait s'attendre à ce qu'un OS embarqué soit plus fiable du fait de l'exigence du marché. Aucun distributeur de GNU/Linux et aucun de ses concurrents directs n'a financé cette étude. Elle devrait donc être objective.

Des outils automatisés ont été utilisés pour détecter quatre types de défauts dans le code : Fuites de mémoire, références à un pointeur nul, mauvaises allocations, accès aux tableaux hors-limites et variables non-initialisées. Reasoning a relevé 8 défauts sur 81 852 lignes de code source du noyau Linux (SLOC - Linux kernel sources lines of code) ce qui donne un taux de 0.1 défaut par KSLOC. Au contraire, les trois OS propriétaires (deux d'entre eux étant des versions d'Unix) ont entre 0.6 et 0.7 défauts/KSLOC. Le noyau Linux a donc un taux d'erreur inférieur aux OS généraux étudiés. Avec un taux de 0.1 et 0.3 erreurs/KSLOC pour les OS embarqués, le noyau Linux est mieux placé qu'un des OS embarqué mais équivalent à l'autre OS embarqué.

Il faut noter que l'outil détecte des erreurs sans gravité. Par exemple, sur 8 erreurs, une était véritablement un bug, mis en évidence et rectifié par les programmeurs et 4 n'affectaient pas le code. Aucun ne concernaient l'aspect sécurité. L'étude a aussi dénombré les problèmes de code résolus sur les divers produits. Il en résulte que le noyau Linux recelait 1 défaut rectifié sur 81.9 KSLOC (soit un taux de 0.013 défauts/KSLOC) alors que les versions propriétaires dénombraient 235 défauts rectifiés sur 568 KSLOC (soit un taux de 0.41 défauts/KSLOC).

Scott Trappe, Directeur Général, remarque que le modèle "open source" encourage des comportements inhabituels dans le domaine de la programmation commerciale. Tout d'abord, beaucoup d'utilisateurs ne se contentent pas de recenser les erreurs de code, comme ils le feraient avec des logiciels propriétaires. Ils en recherchent la cause et les rectifient. De plus, beaucoup de programmeurs lisent le code de leurs collègues pour mieux le comprendre avant de la modifier et l'étendre. Une telle collaboration est le meilleur moyen de trouver des erreurs. D'autre part, le modèle "open source" encourage le coté collaboratif où chaque programmeur apporte sa contribution à l'élaboration d'un projet commun. Les plus efficaces écrivent le code vital, revoient les contributions des autres et décident de l'intégration d'une contribution dans une prochaine version. Enfin, les projets "open source" n'ont pas les mêmes exigences que les projets propriétaires. Les projets "open source" sont rarement développés dans un délai fixé, ce qui permet une meilleure relecture et une phase de test plus efficace.

Cela ne prouve pas que les OSS/FS seront toujours les meilleurs mais cela montre clairement qu'ils peuvent être de très bonne qualité.

5. Selon une évaluation Suisse qui a duré 3 mois, les sites utilisant le logiciel serveur IIS de Microsoft sont en moyenne deux fois plus de temps "hors service" que les sites utilisant Apache. Ce chiffre a été mis en évidence par une analyse de Syscontrol AG le 7 février 2000. Ils ont sondé plus de 100 sites web Suisses réputés pendant trois mois, se connectant sur 4 sites différents toutes les 5 minutes. (il aurait été interessant d'élargir le panel!). Vous pouvez consulter le compte-rendu (en allemand) ou une traduction Babelfish du rapport. Vous trouverez ci-dessous quelques chiffres publiés (heures hors-service durant le mois de référence) pour chaque type de logiciel serveur ainsi que la moyenne trimestrielle.

|

Hors Service |

Apache |

Microsoft |

Netscape |

Autre |

|

Septembre |

5.21 |

10.41 |

3.85 |

8.72 |

|

Octobre |

2.66 |

8.39 |

2.80 |

12.05 |

|

Novembre |

1.83 |

14.28 |

3.39 |

6.85 |

|

Moyenne |

3.23 |

11.03 |

3.35 |

9.21 |

6. Il faut noter qu'Apache obtient les meilleurs résultats sur le trimestre. La différence entre Netscape et Apache est statistiquement insignifiante mais cela montre tout de même que la solution OSS/FS (Apache) est aussi fiable que la meilleure solution propriétaire (Netscape).

7. Le compte-rendu stipule que ce problème n'est pas seulement dû à la qualité du logiciel et précise que plusieurs sites Microsoft IIS subissent de courtes interruptions au même moment, chaque jour, ce qui entraine des redémarrages réguliers.Cependant, une question demeure : " Pourquoi les sites IIS nécessitent des redémarrages réguliers, à l'inverse des sites sous Apache ?". Chaque coupure, même planifiée est dommageable pour le site, surtout si celui-ci est consacré au commerce électronique (perte potentielle de ventes). Il semble que les propriétaires de sites IIS qui effectuent ces redémarrages réguliers, pensent ainsi renforcer la fiabilité de leur système. Cependant, malgré cette politique, les systèmes IIS sont moins fiables que les sites basés sur Apache.

8. Selon une étude sur le temps écoulé entre deux redémarrages (uptime), effectuée pat Netcraft, les OSS/FS se comportent bien. Selon le rapport du 3 aout 2001, sur les 50 sites ayant l'"uptime" le plus long, 92% utilisent Apache et 50% fonctionnent avec des OS OSS/FS. Netcraft a suivi les 50 sites les plus interrogés et ayant le plus long "uptime" sur le site http://uptime.netcraft.com. En consultant the August 3, 2001 uptime report , j'ai trouvé que 92% (46/50) des sites utilisent Apache. Un serveur était inconnu et trois autres n'étaient pas Apache. Sur les trois derniers, un seul s'identifiait comme Microsoft IIS, ce qui est étrange car ce site utilisait l'OS BSD. (cela peut s'expliquer de différentes façons : il existe peut-être un frontal sous BSD qui masque le site sur IIS ou le serveur se préserve des attaques en trompant les auteurs). Dans cet échantillon, 50%(25/50) utilisent un OS OSS/FS et seuls les OS de type Unix détenaient des "uptimes" larges. (aucun système Windows n'a été mentionné comme ayant le meilleur "uptime").

9. Comme dans toutes les études, celle-ci comporte des faiblesses, comme stipulé dans Netcraft’s Uptime FAQ. Leur technique d'identification du logiciel serveur et des OS n'est pas infaillible. Seuls les systèmes pour lesquels Netcraft avair reçu beaucoup de demandes ont été retenus dans l'étude. Elle n'est donc pas représentative de "tous les sites du monde". Tous les sites pour lesquels on fait une demande sur la page « Qu'est-ce qui tourne sur ce site » sont ajoutés à l'échantillon régulièrement vérifié. En effet, pour des raisons de performance, Netcraft ne surveille pas les 22 millions de sites qu'il connait. Beaucoup d'OS ne transmettent pas d'information relative à leur "uptime" et ne peuvent être inclus dans l'étude. Notamment AIX, AS/400, Compaq Tru64, DG/UX, MacOS, NetWare, NT3/Windows 95, NT4/Windows 98, OS/2, OS/390, SCO UNIX, Sony NEWS-OS, SunOS 4, Windows NT et VM. Seuls BSD/OS, FreeBSD (sauf la configuration par défaut des versions 3 et suivantes), les versions récentes de HP-UX, IRIX, GNU/Linux 2.1 kernel et suivant (sauf les systèmes basés sur le processeur Alpha), MacOS X, les versions récentes de NetBSD/OpenBSD, Solaris 2.6 et suivants, et Windows 2000 peuvent être étudiés au niveau de leur temps d'"uptime". Les données relatives aux systèmes Windows 2000 sont prises en compte dans l'étude mais posent un autre problème. Windows 2000 espérait faire partie de la liste d' Août 2001 car le cinquantième de la liste avait un "uptime" de 661 jours et Windows 2000 était mis sur le marché 17 mois avant (soit 510 jours). Mais notez que HP-UX, GNU/Linux , Solaris et les versions récentes de FreeBSD se réinitialisent (cycle back to zero) après 497 jours, comme si la machine avait été redémarrée. Il est donc impossible que ces systèmes ait un "uptime" supérieur à 497 jours, celui-ci peut donc être trompeur. Il y a un autre problème : si un ordinateur change d'OS par la suite, son "uptime" est attribué au nouvel OS. Cette étude compare donc Windows 2000, GNU/Linux (en général jusqu'à 497 jours au maximum), FreeBSD et plusieurs autres OS et les OSS/FS sont bien placés.

On peut arguer que les systèmes qui n'ont pas été redémarrés depuis longtemps ne sont pas significatifs. Par exemple, il se peut que les patches de sécurité ne soient pas régulièrement appliqués. Dans ce cas, un "uptime" long n'est pas une bonne chose. Cependant, il existe un contre-argument de valeur : les systèmes Linux et Unix n'ont pas besoin d'être redémarrés si souvent pour mettre à jour la sécurité du système. Si l'on accepte ce principe, il doit y avoir aussi des systèmes Windows non significatifs. Aussi, seuls les systèmes pour lesquels quelqu'un a fait une demande spécifique ont été retenus dans l'étude, ce qui limite le nombre de systèmes non-significatifs.

Pour conclure, Unix et Linux sont capables de démontrer que leur "uptime" est plus long que leurs concurrents Windows. Il est donc évident qu'ils sont plus fiables.

Bien sûr, on relate beaucoup d'anecdotes à propos de la fiabilité de Windows comparée à celle d'Unix. Par exemple, le programme "Smart Ship" de la Marine est à l'origine d'une panne complète sur le bateau Yorktow en septembre 1997 . Anthony DiGiogio a établi que Windows est "à l'origine des problèmes informatiques de Yorltown". Ron Redman, directeur technique de la Fleet Introduction Division de l'Aegis Program Executive Office, déclara : " il y a eu beaucoup de pannes logicielles associées à Windows NT sur le Yorktown". Redman affirma aussi : "Sous la pression politique, on nous force à faire des choix, comme Windows NT... Sans cette pression, je n'aurais pas choisi cet OS, sutout pour cette application particulière. Si nous avions utilisé Unix, nous aurions eu un système qui n'a pas tendance à s'effondrer."

Il est difficile de mesurer la fiabilité, en raison du délai d'obtention des données dans un environnement réel. On a donc plus de données sur la comparaison d'anciennes éditions de Windows avec d'anciennes éditions de GNU/Linux. Mais ces comparaisons sont raisonnables car elles comparent des produits de même génération. En conclusion, il est évident que, dans beaucoup de cas, les OSS/FS ont une longueur d'avance en matière de fiabilité.

Comparer les performances de GNU/Linux et de Microsoft Windows sur un matériel identique a toujours été l'objet de querelles et les résultats ont toujours été basés sur des croyances. Les OSS/FS ont au moins prouvé qu'ils sont compétitifs et qu'ils sont supérieurs dans de nombreux cas.

Les référents sur lesquels on calcule la performance sont très sensibles aux croyances et à l'environnement. Le meilleur référent sera donc l'environnement que vous vous créerez. Sans cela vous récolterez des mesures erronnées.

Tout d'abord, voici quelques études récentes démontrant la supériorité de certains systèmes OSS/FS, du moins, dans certains cas.

1. En 2002, les mesures de TPC-C database ont mis en évidence qu'un système basé Linux est plus rapide qu'un système basé Windows. Red Hat Linux Advanced Server et Microsoft Windows 2000 Advanced Server ont été testés sur la même configuration. A savoir : un HP ProLiant DL580 doté d'une CPU Intel Xeon 32 cadencée à 900 Mhz sur lequel Oracle 9iRE Edition Entreprise est installé. La solution Red Hat Linux a été plus rapide. Vous pouvez consulter les résultats de Linux et Windows . Notons que HP n'a pas modifié le noyau Linux pour obtenir ces résultats.

2. Le test sur les serveurs de fichiers de PC Magazine, publié en novembre 2001, montre que Linux associé à Samba a surpassé Windows, dans le domaine des protocoles d'échange de fichiers propres à Windows. (Performance Tests: File Server Throughput and Response Times) . Ces données sont vérifiées, dans un premier temps, par rapport au nombre de clients simultanés (jusqu'à 30), dans un deuxième temps, par rapport à tous les types de machines utilisées (Pentium II/233MHz avec 128MiB RAM, Pentium III/550MHz avec 256MiB RAM, et Pentium III/1GHz avec 512MiB RAM, où MiB is 2^20 bytes). Bien sûr, plus les machines étaient puissantes, plus la différence était flagrante. Sur le matériel le plus rapide, gérant le plus grand nombre de clients, GNU/Linux traitait aux alentours de 130MB/sec alors que Windows n'en traitait que 78. (GNU/Linux était plus rapide de 78%).

3. En avril 2002, PC Magazine teste de nouveau les performances des serveurs de fichiers. Linux couplé à Samba dépasse Windows 2000. Samba est plus performant de 100% et peut gérer 4 fois plus de clients. PC Magazine a publié une autre étude qui compare Samba à Windows. Le résumé peut être consulté sur : “Samba runs rings around Win2000.” Ils ont mis en évidence que le logiciel Samba le plus récent dépasse Windows 2000 de 100% en terme de performance . Linux et Samba peuvent aussi gérer 4 fois plus de clients que les systèmes Windows 2000. Jay White, Directeur Informatique chez BF Group, déclare que Samba est un composant logiciel essentiel dans un environnement mixte Windows et Linux. “Notre serveur Samba est en service depuis au moins 394 jours. A part le coût matériel, il me coûte 30 minutes de mon temps chaque année.” Mark Twells, coordinateur, déclare : “Nous possédons six serveurs Samba répartis sur divers machines et traitons près de 1000 utilisateurs”.

4. En terme de performance, selon le magazine Sys Admin, GNU/Linux est supérieur à Solaris (sur Intel), Windows 2000, et FreeBSD. (article : “Which OS is Fastest for High-Performance Network Applications?” dans le magazine Sys Admin de juillet 2001). L'équipe de tests a étudié des architectures de haut niveau et ont mis en évidence la supériorité de GNU/Linux par rapport à Solaris (sur Intel), FreeBSD (un système OSS/FS) et Windows 2000. L'équipe a intentionnellement fait fonctionner les systèmes tels quels, sans les paramétrer, sauf en ce qui concerne l'augmentation du nombre de connections TCP/IP simultannées (qui est nécessaire pour tester le “multi-threading” et les applications asynchrones). Ils utilisent les dernières versions des OS et utilisent exactement la même machine. Ils publient les résultats des deux tests de performance.

Les développeurs FreeBSD contestent les résultats de ces tests, arguant que FreeBSD privilégie la fiabilité et non la vitesse. De plus ils précisent que tout utilisateur désirant une certaine rapidité d'exécution peut régler finement le système. Sys Admin’s a donc effectué d'autres tests après avoir parmétré FreeBSD. L'équipe de test est d'abord passé en mode asynchrone, ce qui rend le système plus rapide (mais augmente le risque de perte d'informations lors d'une micro-coupure). Ce défaut est inhérent à GNU/Linux et facilement rectifiable chez FreeBSD. C'est donc une modification mineure. D'autres modifications ont été apportées : ils ont compilé et intégré 17 patches du noyau FreeBSD et ont utilisé différentes commandes de paramétrage précis. Les autres OS n'ayant pas la chance d'être ajustés ainsi, les résultats n'étaient donc pas équitables.

Dans tous les cas, voici le détail de deux tests de rapidité :

1. Le test “en réel” a mesuré la vitesse avec laquelle une grande quantité d' “e-mail” peut être émise par le serveur de courrier (MailEngine). Aucune différence n'est apparue jusqu'à 100 messages émis simultanéments. Mais, plus le nombre de messages grandissait, plus les systèmes présentaient des différences au niveau de la vitesse d'émission des messages par heure. A 500 messages envoyés simultanément, GNU/Linux était clairement plus rapide que les autres OS sauf le FreeBSD paramétré. Ce dernier présentait des performances similaires à GNU/Linux pour le traitement d'au plus 1000 messages simultanés. Les performances de FreeBSD étaient optimales à 1000-1500 connections simultanées avant de décliner au chiffre de 3000 connections simultanées, contrairement à Linux. A 1 500 envois simultanés, GNU/Linux envoyait 1.3 millions d'e-mails/heure, alors que Solaris en gérait à peu près 1 million et Windows 2000 et FreeBSD-non-paramétré, 0.9 millions.

2. Le “test d'Entree/Sortie sur Disque” créait, écrivait et lisait 10 000 fichiers de même taille placés dans un même répertoire. Plusieurs mesures ont été effecuées en variant la taille des fichiers. Solaris était plus lent que FreeBSD non-paramétré. Free-BSD paramétré, Windows 2000 et GNU/Linux fonctionnaient à la même vitesse dans le traitement des fichiers plus petits (dans certains cas FreeBSD, traitait plus rapidement les fichiers de petite taille – 8 ou 16k). Dès que les fichiers traités sont devenus plus gros (56k à 128k), les différents OS ont commencé à présenter des différences de temps de traitement. GNU/Linux était le plus rapide, suivi par Windows 2000 et FreeBSD. Pour des fichiers de 128k, FreeBSD était moins performant que Windows 2000 de 16% et moins rapide que Linux de 39%. Tous étaient donc plus rapide que FreeBSD-non-paramétré et Solaris. En totalisant ces temps , toute taille de fichiers confondus, on dénombre 542 secondes de traitement pour GNU/Linux, 613 secondes pour Windows 2000, 630 secondes pour FreeBSD-paramétré, 2398 secondes pour FreeBSD non-paramétré et 3990 secondes pour Solaris.

5. GNU/Linux associé à TUX a produit de meilleures valeurs SPEC que Windows/IIS dans plusieurs cas, même lorsque la configuration du lecteur est moins performante. L'organisme SPEC Consortium, développe et entretient toute une série de référents pemettant de rendre les comparaisons plus fiables. On peut comparer Microsoft Windows et GNU/Linux en étudiant les résultats de SPECweb99 (qui mesurent les performances des serveurs web sur le même matériel). Malheureusement, on a rarement la même plateforme de test pour tous les OS. Même si ce problème est résolu (dans le test du 13 juillet 2001), la configuration est rarement identique (nombre de disques durs différent, disques plus rapides). Dans le test du 13 juillet 2001, on trouvait trois configurations matérielles différentes, toutes de chez Dell, qui fonctionnent sous GNU/Linux (couplé à TUX, l'accélérateur de serveur web) et Windows (sous IIS) basées sur le même matériel. Le tableau ci-dessous présente les résultats du SPECweb99 en date du 13 juillet 2001.

|

System |

Windows SPEC Result |

Linux SPEC Result |

|

Dell PowerEdge 4400/800, 2 800MHz Pentium III Xeon |

1060 (IIS 5.0, 1 network controller) |

2200 (TUX 1.0, 2 network controllers) |

|

Dell PowerEdge 6400/700, 4 700MHz Pentium III Xeon |

1598 (IIS 5.0, 7 9GB 10KRPM drives) |

4200 (TUX 1.0, 5 9GB 10KRPM drives) |

|

Dell PowerEdge 8450/700, 8 700MHz Pentium III Xeon |

7300/NC (IIS 5.0, 1 9Gb 10KRPM and 8 16Gb 15KRPM drives) then 8001 (IIS 5.0, 7 9Gb 10KRPM and 1 18Gb 15KRPM drive) |

7500 (TUX 2.0, 5 9Gb 10KRPM drives) |

6. La première ligne n'est pas significative. Le système IIS était plus lent mais possédait un contrôleur de réseau alors que le système TUX en possède deux.

7. La deuxième ligne montre que GNU/Linux associé à TUX est bien plus performant malgré l'ajout de deux disques sur le système IIS, ce qui aurait dû améliorer ses performances.

8. La dernière ligne est plus compliquée. Les disques sont différents et le système IIS possède au moins un disque qui tourne plus rapidement que sur le système TUX (ce qui devrait procurer à IIS la meilleure performance puisque la vitesse de transfert est sûrement plus élevée). De plus le système IIS possédait plus de DD (disk drive), ce qui, encore, aurait pu assurer à ce système une meilleure performance.Quand j'ai regroupé ces informations montrant les conclusions d'avril 2201 (données collectées entre le 3ième trimestre 1999 et le 1er trimestre 2001), IIS 5.0 (sur un 8-processor Dell PowerEdge 8450/700) avait une valeur SPECweb99 de 7300. Depuis, Microsoft a modifié la disponibilité de Microsoft SWC 3 et cela signifie que les résultats ne sont pas conformes aux directives de SPECweb99. C'est une démarche subtile : ce n'est pas que les tests étaient invalidés, c'est Microsoft qui a modifié la disponibilité du produit et qui a utilisé les propres règles du Consortium SPEC pour rendre un résultat inexploitable (peut-être pour cacher des conclusions indésirables). Un test a de nouveau été effectué, cette fois avec une autre configuration de disque. IIS atteint alors une valeur de 8001 selon l'échelle du SPECweb99. Ces derniers bons chiffres résultent d'une meilleure configuration matérielle.

9. Ainsi, dans ces configurations, GNU/Linux couplé à TUX était installé sur du moins bon matériel mais ne perdait pas en terme de performance. Puisque d'autres facteurs peuvent être invoqués, il est difficile d'émettre un jugement. Dans certains cas, un meilleur matériel peut être moins performant, ou un facteur non connu peut avoir des effets sur le résultat. Il est souhaitable que dans l'avenir, les tests soient effectués de manière équivalente, avec des configurations identiques.

10. Souvent, on a tendance à utiliser TUX comme “accélérateur web” . Cela est dû à la rapidité avec laquelle il prend en charge les requêtes simples avant d'interroger de façon plus complexe un autre serveur (en général Apache). J'ai présenté les chiffres relatifs aux performances de TUX car ce sont les chiffres les plus récents que je possède .Aujourd'hui, je n'ai aucun résultat de type SPECweb99 relatif à Apache sur GNU/Linux ou à Apache couplé à TUX. Je n'ai pas non plus d'évaluation relative à la fiabilité de TUX. J'espère que de telles mesures seront effectuées.